우리가 어릴때 부터 알고 있는 컴퓨터의 중앙연산처리장치.

컴퓨터의 두뇌라고 늘 얘기하던 것이 CPU (Central Processing Unit)이다. 컴퓨터의 계산은 다 CPU가 하는 줄 알고 있지만, 사실 인공지능을 처리하는 칩은 CPU가 아니라 GPU다.

문제는 이 GPU 가격이 기존 CPU에 비해 턱없이 비싸고, 또한 공급이 달리다 보니 가격이 치솟는 경우가 자주 발생했다. AI 시대의 승자는 마이크로소프트, 구글이 아니라 이 GPU를 공급하고 있는 엔비디아 라는 얘기도 한다. 서부 대개척시대의 금광캐던 시절 청바지 회사가 돈벌 듯 말이다. AI 시대의 청바지가 GPU란 얘기다. 흥미롭다.

|

CPU vs GPU

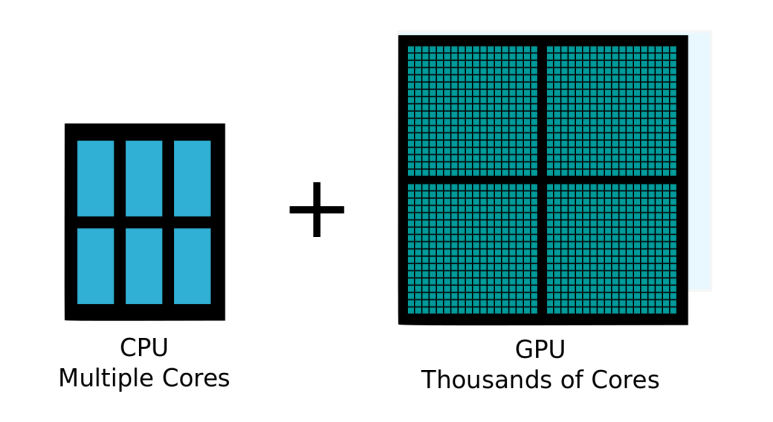

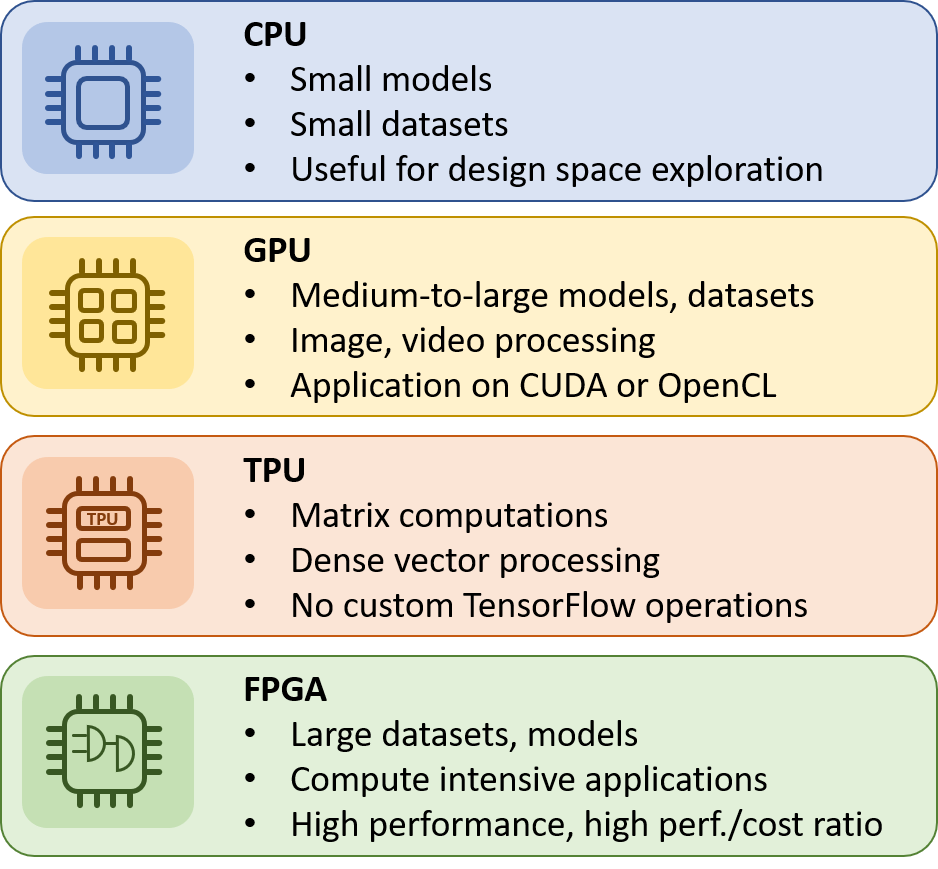

CPU(중앙 처리 장치)와 GPU(그래픽 처리 장치)는 컴퓨터의 두 가지 중요한 구성 요소입니다. CPU는 프로그램 명령 실행 및 산술 연산 처리와 같은 일반적인 컴퓨팅 작업을 수행하는 반면 GPU는 이미지, 비디오 렌더링 및 비디오 게임에 특화되어 있습니다.

CPU와 GPU는 모두 서로 다른 유형의 작업을 처리하도록 설계되었으며 성능을 최적화하기 위해 서로 다른 아키텍처를 사용합니다. CPU에는 더 많은 수의 코어와 스레드가 있어 멀티태스킹, 웹 브라우징 및 데이터 처리와 같은 복잡한 멀티스레드 작업을 처리하는 데 적합합니다. 반면에 GPU는 많은 수의 유사한 작업을 병렬로 수행할 수 있는 단순하고 전문화된 코어를 많이 가지고 있어 까다로운 그래픽 및 비디오 처리 응용 프로그램에 이상적입니다.

요약하면 CPU와 GPU의 차이점은 아키텍처, 처리하도록 설계된 작업 유형 및 제공하는 처리 능력에 있습니다. CPU는 범용 컴퓨팅 작업을 위해 설계되었으며 GPU는 까다로운 그래픽 및 비디오 처리 응용 프로그램을 위해 설계되었습니다.

|

“챗GPT 검색 비용, 일반 검색보다 100~200배 비싸… 고성능·저전력 AI반도체 시급”

“챗GPT, 일반 검색보다 100~200배 비싸”

“현재 많이 쓰이는 GPU, 가격 비싸다”

정부, ‘K-클라우드’ 추진… 국산 AI반도체 개발

글로벌 인공지능(AI) 연구소 오픈AI가 개발한 대화형 챗봇 AI ‘챗GPT(ChatGPT)’의 등장으로 초거대 생성형 AI 기술이 큰 관심을 받고 있다. 하지만 사람들의 관심과 함께 이용량이 많아지면서 챗GPT의 속도가 오히려 떨어지는 부작용도 나타나고 있다. 과학기술계에선 초거대 생성형 AI 기술의 향방이 결국 하드웨어인 AI반도체로 운영비를 얼마나 낮추느냐에 달려 있다고 보고 있다.

한국공학한림원은 10일 ‘대한민국 초거대 AI 시대를 열어가기 위한 AI반도체 기술’이라는 주제로 웨비나를 개최했다. 발표자로는 이동수 네이버클라우드 이사와 박성현 리벨리온 대표, 김주영 한국과학기술원(KAIST) 전기전자공학부 교수, 윤두희 과학기술정보통신부 정보통신방송기술정책과장이 나섰다.

이번 웨비나에서는 챗GPT의 운영비를 두고 AI반도체 개발의 필요성이 제기됐다. 최근 오픈AI 최고경영자(CEO) 샘 알트만은 챗GPT가 하나의 답변을 내놓는 데 ‘한 자릿수 센트(Single-digit cent)’의 비용이 들어간다고 밝혔다. 출시 두 달 만인 지난달 활성 사용자 수가 1억명을 기록한 점을 고려하면 연 수조 원의 운영비가 들어갈 것이라는 전망이 나온다.

이동수 이사는 “챗GPT 답변 비용은 일반적인 텍스트 기반 검색보다 100~200배 더 비싼 수준”이라며 “하루 1500만명이 챗GPT를 사용한다고 가정하면 하루에 수십억 원, 1년에 수조 원이 운영비로 들어간다는 계산이 나온다”고 말했다.

거대 AI에 주로 사용되는 반도체 병렬 처리 방식 그래픽처리장치(GPU)의 비용이 너무 비싸다는 의견도 있었다. 현재 사용되고 있는 GPU는 엔비디아가 80% 이상의 점유율을 차지하고 있다. 김주영 교수는 “대부분 AI에 GPU를 쓰고 있지만, 말도 안 되게 비싼 가격”이라며 “또 무겁고 큰 디바이스라서 새로운 시장을 GPU로 따라가긴 어렵다”고 설명했다. <기사출처>

'테크놀로지' 카테고리의 다른 글

| GPT 이해, 그리고 인공지능 #ChatGPT #GPT (0) | 2023.02.12 |

|---|---|

| 사라진 갈락티카, 그리고 곤경에 처한 바드 #구글 #메타 #챗GPT (0) | 2023.02.12 |

| 챗GPT가 쏘아올린 공에 흔들리는 구글 #알파벳 #주가급락 (0) | 2023.02.12 |

| 어떻게 AI가 쓴 글을 구별할까? #챗GPT #텍스트감지기 (0) | 2023.02.04 |

| 챗GPT에 관한 6가지 비밀 #챗GPT #비밀 (0) | 2023.02.04 |